O que é o robots.txt?

O robots.txt é um arquivo de texto simples localizado na raiz de um site, que orienta os crawlers (robôs dos buscadores, como o Googlebot) sobre quais páginas eles podem ou não acessar. Esse arquivo faz parte do protocolo de exclusão de robôs (Robots Exclusion Protocol – REP), que é um conjunto de regras usadas pelos mecanismos de busca para entender melhor os sites.

Ou seja, ele não impede que uma página seja acessada diretamente por um usuário, mas sim que os mecanismos de busca a indexem ou naveguem por ela.

Exemplo de um arquivo robots.txt básico

User-agent: *

Disallow: /admin/

Allow: /produtos/

Sitemap: https://www.dominio.com.br/sitemap.xml

O que esse código faz?

Permite que todos os robôs acessem o site (User-agent: *)

Bloqueia o acesso à pasta /admin/ (Disallow: /admin/)

Permite que a alguma pasta seja acessada normalmente (Allow: /blog/)

Para que serve o arquivo robots.txt?

O robots.txt tem diversas funções importantes para a gestão do seu site. Algumas das principais utilidades incluem:

- Evitar que áreas sensíveis do site sejam rastreadas – como paineis administrativos e páginas internas.

- Otimizar o rastreamento do site – ajudando o Google a focar nas páginas mais importantes.

- Proteger arquivos sensíveis – como arquivos de configuração ou pastas privadas.

No entanto, é importante lembrar que o robots.txt não é um método de segurança. Se você quiser impedir completamente o acesso de pessoas ou robôs a certas páginas, deve usar métodos como autenticação ou proteção por senha.

Principais diretivas do robots.txt

O arquivo robots.txt funciona por meio de algumas regras básicas, chamadas de diretivas. As principais são:

User-agent

Define para quais robôs a regra se aplica. Pode ser um robô específico (como o Googlebot) ou todos (*).

Exemplo:

User-agent: Googlebot

Isso significa que a regra será aplicada apenas ao Googlebot.

Disallow

Bloqueia o acesso a determinadas páginas ou diretórios do site.

Exemplo:

Disallow: /admin/

Isso impede que os robôs acessem a pasta /admin/.

Allow

Permite o acesso a determinadas páginas, mesmo dentro de pastas bloqueadas.

Exemplo:

Disallow: /blog/

Allow: /blog/publico/

Aqui, todo o blog está bloqueado, exceto a pasta /blog/publico/.

Sitemap

Ajuda os robôs a encontrar o sitemap.xml, facilitando a indexação de páginas disponíveis do site.

Exemplo:

Sitemap: https://www.seusite.com/sitemap.xml

Para que servem os comandos Allow e Disallow?

O Allow e o Disallow são os comandos que determinam quais partes do seu site podem ser acessadas ou não pelos robôs de pesquisa.

Allow – indica qual página deseja indexar nos resultados de busca.

Disallow – comando usado para não indexar páginas nos resultados de pesquisa.

O Googlebot segue as regras do robots.txt, mas outros robôs maliciosos podem ignorá-las. Ou seja, se você quiser proteger dados sensíveis, use autenticação e outras medidas de segurança.

Por que o robots.txt é importante?

Um robots.txt bem configurado pode fazer toda a diferença para um site, garantindo que:

O Google rastreie as páginas certas – evitando desperdício de tempo e recursos com páginas irrelevantes.

Páginas internas ou duplicadas não sejam indexadas – evitando problemas de SEO.

Seu site seja mais eficiente – ajudando os motores de busca a focarem no conteúdo relevante.

Como encontrar o robots.txt de um site?

Quer ver o robots.txt de qualquer site? Basta acessar o seguinte link no seu navegador:

https://www.nomedosite.com/robots.txt

Se o arquivo existir, ele será exibido na tela. Caso contrário, o site pode não ter um robots.txt configurado.

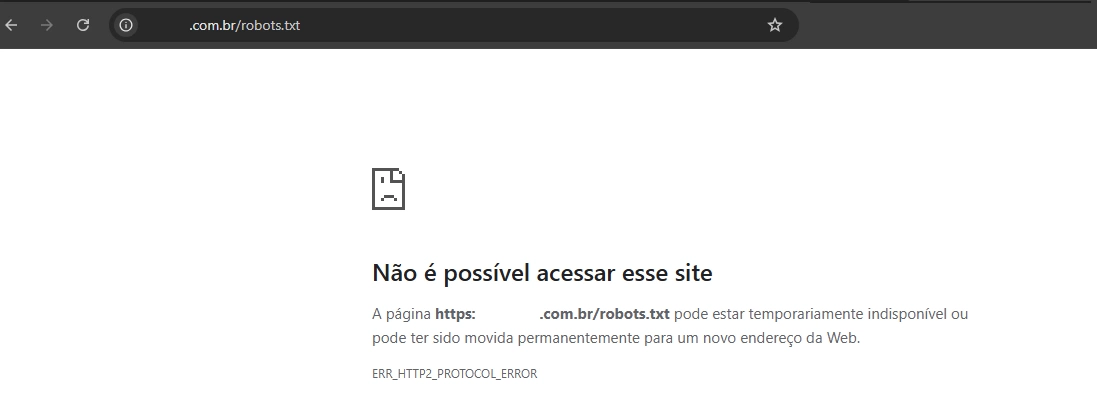

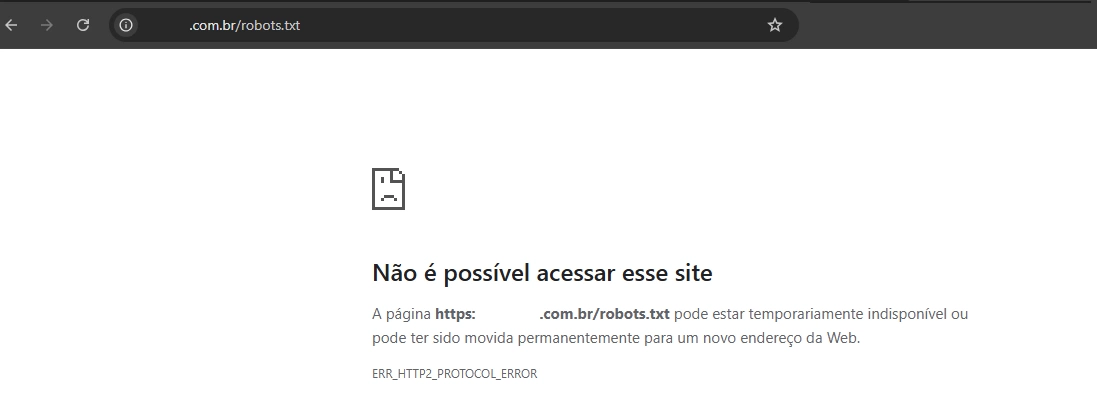

Um exemplo de robots.txt não configurado:

Como criar um arquivo robots.txt?

Criar um robots.txt é muito simples! Entenda como funciona:

Você pode usar o bloco de notas, VS Code ou qualquer editor de texto simples.

Escreva as regras do seu arquivo, por exemplo:

User-agent: *

Disallow: /admin/

Allow: /produtos/

Sitemap: https://www.seusite.com/sitemap.xml

Salve como robots.txt (formato .txt)

-

Envie para a raiz do site

Faça o upload do arquivo para a pasta principal do seu site (“/”). O caminho correto será:

https://www.seusite.com/robots.txt

-

Avalie no Google Search Console

No Google Search Console, você pode avaliar se seu arquivo de robots.txt e ver se ele está funcionando corretamente.

Como a Domatech pode te ajudar?

O arquivo robots.txt pode parecer um detalhe pequeno, mas tem um papel fundamental na otimização do seu site para os mecanismos de busca. Com ele, você pode controlar o que será indexado, como os robôs vão interagir com suas páginas e otimizar o rastreamento.

Se você ainda não fez essa configuração no seu site, agora é a hora de fazer isso! E se precisar de ajuda com as boas práticas de SEO ou desenvolvimento de sites, conte com o time de especialistas da Domatech. Juntos, podemos levar o seu negócio para o próximo nível. Entre em contato conosco!

SOLUÇÕES PERSONALIZADAS

SOLUÇÕES PERSONALIZADAS INOVAÇÃO TECNOLÓGICA

INOVAÇÃO TECNOLÓGICA SOLUÇÕES PERSONALIZADAS

SOLUÇÕES PERSONALIZADAS INOVAÇÃO TECNOLÓGICA

INOVAÇÃO TECNOLÓGICA SOLUÇÕES PERSONALIZADAS

SOLUÇÕES PERSONALIZADAS INOVAÇÃO TECNOLÓGICAprojetos

INOVAÇÃO TECNOLÓGICAprojetos Conheça nossos projetos

Conheça nossos projetos Conheça nossos projetos

Conheça nossos projetos Conheça nossos projetos

Conheça nossos projetos Conheça nossos projetos

Conheça nossos projetos Conheça nossos projetos

Conheça nossos projetos Conheça nossos projetossobre

Conheça nossos projetossobre DREAMTEAM

DREAMTEAM TECNOLOGIA

TECNOLOGIA DREAMTEAM

DREAMTEAM TECNOLOGIA

TECNOLOGIA DREAMTEAM

DREAMTEAM TECNOLOGIAnossa história

TECNOLOGIAnossa história DREAMTEAM

DREAMTEAM TECNOLOGIA

TECNOLOGIA DREAMTEAM

DREAMTEAM TECNOLOGIA

TECNOLOGIA DREAMTEAM

DREAMTEAM TECNOLOGIAcarreiras

TECNOLOGIAcarreiras ALCANCE AS ESTRELAS

ALCANCE AS ESTRELAS SONHE GRANDE

SONHE GRANDE ALCANCE AS ESTRELAS

ALCANCE AS ESTRELAS SONHE GRANDE

SONHE GRANDE ALCANCE AS ESTRELAS

ALCANCE AS ESTRELAS SONHE GRANDEcontato

SONHE GRANDEcontato DECOLE COM A GENTE

DECOLE COM A GENTE MISSÃO

MISSÃO DECOLE COM A GENTE

DECOLE COM A GENTE MISSÃO

MISSÃO DECOLE COM A GENTE

DECOLE COM A GENTE MISSÃOblog

MISSÃOblog MUNDO TECH

MUNDO TECH NEWS

NEWS MUNDO TECH

MUNDO TECH NEWS

NEWS MUNDO TECH

MUNDO TECH NEWS

NEWS